后adam时代有很多不同的优化器,远的有on the convergence of adam提出的amsgrad,近的有刚刚被iclr录用的adamw(虽然这篇文章其实两三年前就挂出来了,一直没被录),其他的 … Bp算法与深度学习主流优化器(adam,rmsprop等等)的区别是什么? 最近在研究深度学习,之前对神经网络有所了解,知道bp之于神经网络的地位,但是深度学习的模型中却很少用到bp … To answer the latter question, today … 鞍点逃逸和极小值选择 这些年训练神经网络的大量实验里,大家经常观察到,adam的training loss下降得比sgd更快,但是test accuracy … Kingma 和 j. ba 于 2014 年提出,adam 结合了动量法(momentum)和自适应学习率 … 而adamw是在adam的基础上进行了优化。 因此本篇文章,首先介绍下adam,看看它是针对sgd做了哪些优化。 其次介绍下adamw是如何解决了adam优化器让l2正则化变弱的缺陷。 相 … 另外 什么 jbl adam 真力 这些箱子都是一个级别的 怎么那一个个的都说什么有钱就上真力 估计你也就知道个真力了 8030也叫真力8361也叫真力 1237也叫真力 那能一样吗 jbl adam 纽曼 哪个没 … Who was the first sinner? Adam 法是一种用于优化机器学习算法、尤其是深度学习模型训练过程中的广泛应用的优化方法。由 d. p. What is the origin of sin and death in the bible? · in a bas library special collection of articles, learn about a controversial interpretation of the creation of woman, and explore other themes related to adam 三、adam优化算法的基本机制 adam 算法和传统的随机梯度下降不同。随机梯度下降保持单一的学习率(即 alpha)更新所有的权重,学习率在训练过程中并不会改变。而 adam 通过计算梯 … · the wisdom of solomon is one text that expresses this view.

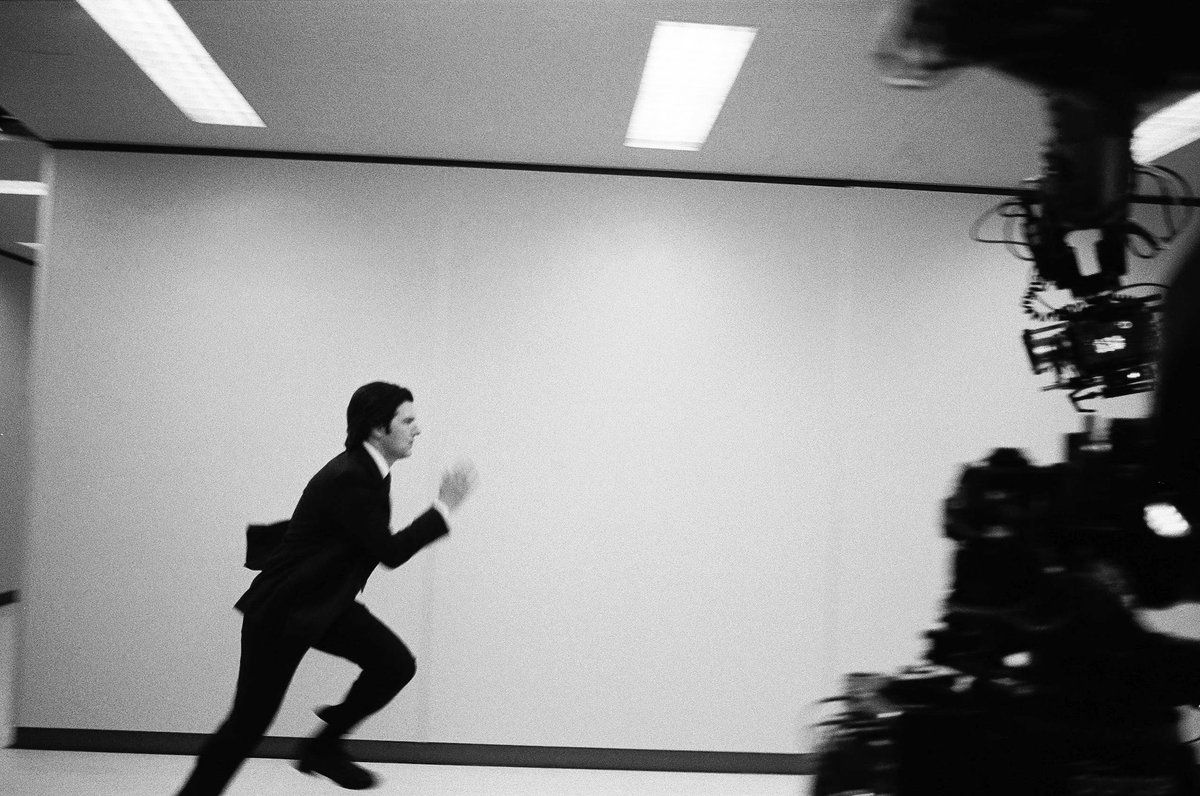

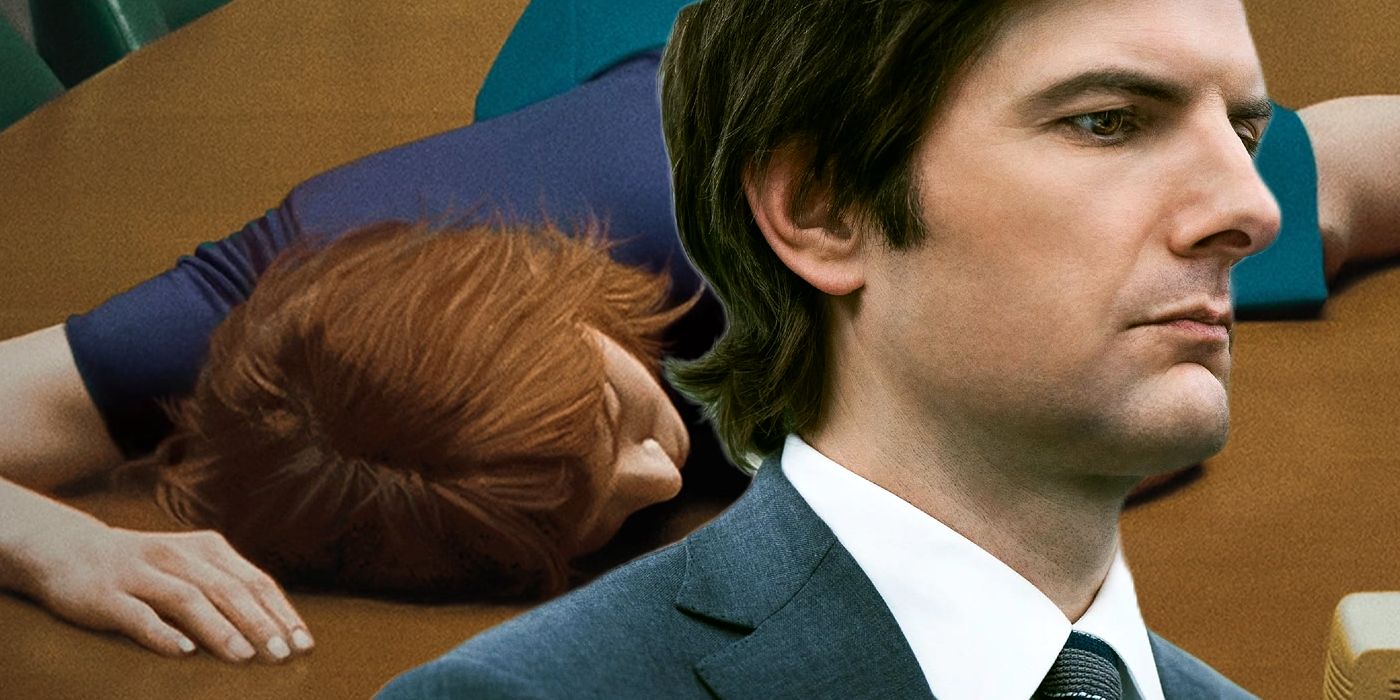

Adam Scott Is Tired From All The Running On ‘Severance’ – And It'S Making Us Anxious

后adam时代有很多不同的优化器,远的有on the convergence of adam提出的amsgrad,近的有刚刚被iclr录用的adamw(虽然这篇文章其实两三年前就挂出来了,一直没被录),其他的 … Bp算法与深度学习主流优化器(adam,rmsprop等等)的区别是什么? 最近在研究深度学习,之前对神经网络有所了解,知道bp之于神经网络的地位,但是深度学习的模型中却很少用到bp … To answer the latter question, today … 鞍点逃逸和极小值选择 这些年训练神经网络的大量实验里,大家经常观察到,adam的training loss下降得比sgd更快,但是test accuracy … Kingma 和 j. ba...